Inhalt: [-]

- 1 Flüchtige Informationen

- 2 Analoge Medien sind robuster

- 3 Halt- und Lesbarkeit der Medien

- 4 Analoge Medien der Vergangenheit

- 5 Und heute?

- 6 Datenverlust vorprogrammiert?

- 7 Vergessene Datenträger

- 8 Unsere Enkel

- 9 Wer besitzt Dein Leben?

- 10 Datenschutz und Bildung im Neuland

- 11 Rettungsbemühungen

- 12 Arten von Daten (grobe Einteilung)

- 13 Ist „Big Data“ die Lösung?

- 14 Fazit

Digitales Vergessen bedroht die zukünftige Geschichtsschreibung. Vielleicht wird man in wenigen Jahrzehnten nicht mehr wissen, wie wir heute gelebt haben. Können digitale Daten einfach so „verschwinden“?

VORWORT:

Dieses Thema ist sehr komplex, behandelt es doch eigentlich alle Aspekte unseres modernen Lebens. Wir leben in einem digitalen Zeitalter, gehen aber mit unserer jüngsten Vergangenheit sehr sorglos um. Hier möchte ich einen – zugegebener Massen etwas umfangreichen – Denkanstoß geben, sich selber mit den Teilaspekten zu beschäftigen. Aus diesem Grunde habe ich sehr viele Links zu anderen Webseiten eingefügt. Die meisten davon verweisen auf die Wikipedia, da mir diese momentan am zuverlässigsten in Sachen Verfügbarkeit erscheint. Ich bin mir sicher, dass die Wikipedia-Links alle noch erreichbar sind, wenn dieser Artikel längst verschwunden ist. Die Wikipedia ist keine Quelle, aber sie reicht um sich unverbindlich einen Überblick über ein Thema zu verschaffen – zumal es hier eher um „harte“ Fakten zu Themen der IT geht.

Flüchtige Informationen

Immer wieder hörst Du: „Das Internet vergisst nichts!“ Klar, die peinlichen Partybilder, mit denen sich Deine Kinder (oder Du selbst?) bis auf das Mark blamiert haben, bekommt man seltsamer Weise nicht mehr aus dem Netz. Aber suche doch mal eine Bedienungsanleitung für einen „alten“ Fernseher oder die letzte Firmware für einen DVD- oder Bluray-Player. Nach drei, vier Jahren sind die tatsächlich von den Herstellerwebsites verschwunden. Informationen zu jüngsten politischen und gesellschaftlichen Veränderungen? Von den Nachrichtenseiten und aus den sozialen Netzwerken verschwunden!

[irp posts=“681″ name=“Was ist eigentlich Datenschutz?“]

[irp posts=“671″ name=“Warum ich etwas zu verbergen habe“]

Das Problem der digitalen Demenz ist also tatsächlich real. Wir leben immer mehr in einer papierlosen Welt. Datenmengen, die ganzen Staatsbibliotheken entsprechen, kann man mit einem unbedachten Mausklick in einem Sekundenbruchteil löschen. Bei den gigantischen Datenmengen, die (nicht nur) die Unternehmen horten, muss das zwangsweise nicht einmal jemandem auffallen. Backups werden auch nicht für alle Ewigkeit aufgehoben.

[irp posts=“685″ name=“Was ist eigentlich Big Data?“]

Aber lasst uns erst einmal eine Exkursion durch die Wunderwelt der Datenträger und Medien machen. Archäologie muss sich nicht zwangsweise mit Epochen beschäftigen, die bereits vor Äonen zu Ende gingen. Bevor wir es uns versehen, haben bereits unsere Enkel kein genaues Bild mehr von unserem Leben.

Analoge Medien sind robuster

Ein Fotoalbum (ein Buch generell) brennt tatsächlich eher schlecht. Wenn eine Wohnung oder ein Gebäude ausbrennt, dann werden diese Schätze an den Kanten angekohlt sein. Das größte Risiko ist das Löschwasser, nicht die Flammen. So ein Buch steht vielleicht fünfzehn Minuten im Feuer, bis die Löscharbeiten beginnen. Es wird nicht mehr hübsch sein, aber der Inhalt wird noch weitgehend zu lesen sein. Die externe Festplatte mit zig Terabyte an Daten (das entspricht der ganzen Stadtbücherei einer Großstadt) ist – wenn überhaupt – nach dieser Zeit nur noch durch Forensiker zu enormen Kosten auslesbar. Das Feuer muss nicht einmal das Regal erreichen, die Strahlungshitze, die den Einband eines Buches nur ansengt, beschädigt die Beschichtung der Festplattenscheiben irreparabel und lässt optische Datenträger und Bandkassetten schmelzen.

Physikalische Beschädigungen

Digitale Medien sind davon weitaus stärker betroffen als analoge. Aus einer alten VHS-Kassette, deren Band beschädigt wurde, kann ich die betroffenen Stellen einfach rausschneiden und das Band wieder zusammenfügen. Es fehlt zwar nun einiges an Information, aber ich kann das Band im Recorder problemlos abspielen. Hat ein optischer Datenträger Beschädigungen in der Datenschicht, z.B. durch einen Kratzer von der Oberseite(!) der Disk her, wird es sehr schwer sein, diesen wieder zu retten. Die Beschädigung betrifft in dem Falle nicht nur einen einzelnen Datensatz auf dem Datenträger, sondern im Prizip fast jede darauf gespeicherte Information, wenn auch im wesentlich geringerem Umfang.

Wird der Bereich mit den Dateizuordnungen auf einem magnetischen Datenträger physikalisch Beschädigt, muss ein Datenrettungsbetrieb ran. Setzt man eines dieser üblichen Datenrettungstools an, so verzichtet man i.d.R. auf die kompletten Dateinamen und -endungen, bekommt also nur noch „Blankodateien“, die oft genug auch noch beschädigt sind. Solche Dateien können ein Bild, ein Mailfile, oder ein Word-Dokument sein, man sieht es dem File nicht mehr an.

Natürlich darf man nun nicht denken, dass die alten Videobänder unversehrt die Lagerung über lange Zeiten überstehen. Das Gegenteil ist der Fall, die Qualität wird immer schlechter, je älter das Band wird. Besonders mehrfach bespielte Bänder sind problematisch. Hier sollte man also schnell handeln und die Bänder auf ein zeitgemäßes digitales Medium kopieren. Die noch älteren Super-8-Filme sind da deutlich haltbarer.

Je niedirger also die Informationsdichte in einem Datenträger ist, desto weniger schnell können Informationen darauf beschädigt werden.

Beschädigungen durch Software

Auch ein sehr interessantes Thema ist die Formatierung externer Festplatten. Um diese auch noch für ältere Betriebsysteme wie Windows XP (das schon lange nicht mehr mit Sicherheitsupdates versorgt wird, an dem aber immer noch viele User hängen) kompatibel zu machen, die nichts mit der Sektroengröße von 4 KByte beim Advanges Format moderner Festplatten anfangen kann, gaukelt die Elektronik des externen Festplattengehäuses dem Betriebsystem eine Sektorengröße von nur 512 Bytes vor. Erleidet die Elektronik in dem Gehäuse einen Defekt und baut man die Platte nun in einen Rechner intern ein, so wird das Dateisystem als unpartitioniert angezeigt werden, da nun die „512 Emulation“ fehlt.

Wenn nun ein ähnliches externes Gehäuse vorhanden ist, dass für eine (nicht identische) Umwandlung der Sektorengröße sorgt, ist die Problematik die gleiche wie bei defekten Dateizuordnungen: man weiß nicht mehr was für Daten wo auf der Festplatte gespeichert sind und müsste die gesamte Platte Bit für Bit auslesen um daraus eine Dateizuordnung zu rekonstruieren. Dabei kann nicht unterschieden werden, ob die gefundenen Daten zu einer gelöschten Datei gehört, die vielleicht sogar teilweise überschrieben wurde. Viele Zuordnungen müssen geschätzt werden, so dass am Ende meist ein heilloses Durcheinander entsteht. Die Dateinamen sind i.d.R. nicht mehr zu retten, so dass man am Ende im Zweifel Millionen Dateien hat, aus den man die relevanten herausfinden müsste.

Gerade unter dem Betriebsystem Windows ist Schadsoftware (Viren, Trojaner, Würmer, etc.) ein massives Problem. Nicht nur die Schadsoftware an sich kann die Daten beschädigen, auch der Virenscanner kann beim Entfernen die Dateien verändern. Wie zuverlässig ist die Information in einer geänderten Datei? Bei forensischen Untersuchungen spielt dieser Aspekt durchaus eine Rolle.

„Gefälschte“ Informationen

Verfälschte Informationen? Wie das? Erinnert sich noch jemand an den „Xerox-Skandal“ vor einigen Jahren? Die großen Scannersystem von Xerox, die in vielen Firmen eingesetzt werden, die das papierlose Büro vorantreiben, „fälschten“ die eingespannten Dokumente. Findige Ingenieure kamen auf die Idee, dass man zur optimalen Komprimierung nicht nur ähnliche Pixel in einer Grafik (etwas anders ist ein Scan nicht) zusammenfassen könnte, sondern durch die OCR (Optical Character Recognition, Texterkennung) auch komplette ähnliche Zeichen (Buchstaben, Zahlen, Sonderzeichen) in einem Dokument durch einen einzigen ersetzen könnte. Würden in einem Dokument also beispielsweise 400 große „A“ vorkommen, so müsste man nur einmal eines dieser „A“ als kleine Pixelgrafik speichern und diese dann an allen anderen Stellen, die ein „A“ enthielten, einsetzen.

Die Ergebnisse sehen echt aus und fallen nur auf, wenn man nach Anzeichen für eine Fälschung sucht. So auch geschehen bei der Geburtsurkunde des US-Präsidenten Barak Obama. Diese wurde augenscheinlich mit einem Xerox-System eingescannt und veröffentlicht. Verschwörungstheoretikern fielen die vielen exakt gleichen Buchstaben in der Urkunde auf. Eigentlich sollten sich die einzelnen Buchstaben hinreichend voneinander unterscheiden, wenn man das Dokument vergrößert, da das Original immer ganz leicht schräg eingezogen oder aufgelegt wird.

Hierzu empfehle ich das ebenso unterhaltsame wie erhellende und erschreckende Video von David Kriesel.

Halt- und Lesbarkeit der Medien

Das wirklich interessante (Grund-)Problem ist doch ein ganz anderes: Womit kann ich die Daten wieder auslesen, wenn (falls!) sie einen längeren Zeitraum unbeschadet überstanden haben? Eine Steintafel, eine Pergamentrolle, eine Tontafel oder ein Buch kann ich problemlos direkt und ohne Hilfsmittel lesen, wenn ich die Sprache verstehe. Auch alte Filmstreifen kann ich mir ansehen, zu Not mit einer einfachen Lupe. Gleiches gilt für Microfiche. Selbst eine Schallplatte kann man sich mit einfachsten Mitteln anhören. Zwei Schallplatten wurden deshalb sogar in den Weltraum geschickt.

Vielleicht wird man sich aber bereits in 100 Jahren fragen, wie wir – die Menschen der digitalen Gegenwart – überhaupt gelebt haben. Jahrtausende alte Schriften, die in Stein gehauen wurden, haben Kriege, Katastrophen und Kulturen überlebt – auch Bücher aus Leder, Pergament oder schnöden Papier überdauerten die Jahrhunderte und gewähren uns heute einen Einblick in das damalige Leben aus Gesellschaft, Politik, Wissenschaft und Kunst. Leider ist nicht jede Papiersorte zur Langzeitarchivierung geeignet. Gerade die Sorten, die mit der Industrialisierung eingeführt wurden, leiden unter Papierzerfall durch verschiedene Faktoren.

(Nachdruck einer taiwanischen Schrift)

Magnetische Medien

Es ist allgemein bekannt, dass bei magnetischen Medien die Beschichtung bereits durch einen unsachgemäßen Ausleseversuch irreparabel beschädigt werden kann? Dass nicht jedes dafür eigentlich geeignete Lesegerät die Daten auch korrekt auslesen kann, weil die Leseköpfe durch Serienschwankungen leicht unterschiedlich eingestellt sind? Dass die Antriebsriemchen in den Laufwerken mit den Jahren verspröden und Ersatz nicht für Geld und gute Worte zu bekommen ist? Dass es nicht die Frage ist, ob ein digitaler Datenspeicher kaputt geht, sondern nur wann?

Optische Medien

Selbst gebrannte CDs, DVDs und BluRays halten in etwa fünf bis zehn Jahre, bevor die organische Speicherschicht zerfällt und sie unlesbar werden. Gepresste CDs, DVDs und BRs halten bis zu 80 Jahre. Einzig die M-Discs sollen laut Hersteller angeblich bis zu 1.000 Jahre halten. Wobei die Frage gestattet sein darf, womit man in 1.000 Jahren eine M-Disc eigentlich auslesen kann.

Flash (NAND)-Medien

Flashspeicher, scheint von den digitalen Datenträgern bisher der zuverlässigste in Hinblick auf die Langzeitarchivierung zu sein. Er altert eigentlich nur durch Löschvorgänge, bei denen die Oxidschicht der Speicherzellen immer wieder leicht beschädigt wird.

Analoge Medien der Vergangenheit

Vielleicht hast Du im Album noch Bilder Deines Urgroßvaters? Diese kannst Du jederzeit und ohne Hilfsmittel ansehen. Stelle Dir sich vor, er hätte die Bilder mit einer Art Digitalkamera gemacht und auf einer Schelllackplatte oder einer Wachstrommel abgespeichert – Du hättest dann heute die gleichen Probleme wie sie Deine Kinder mit Super-8-Filmen haben und Deine Enkel mit Digitalkamerabildern haben werden. Es wird schlicht kein Abspielgerät mehr geben oder zumindest niemanden, der ein vorhandenes noch reparieren könnte.

(Mein Urgroßvater in seinem zweiten Weltkrieg)

(v.r.n.l.: 36mm Kleinbildfilm, Super 8-Filmkassette (unentwickelt), SmartMediaCard, xD-Card)

(Kodak, entwickelte Super 8-Filmrolle mit 250m Länge (ca. 33 min. Spielzeit), 1964)

Und heute?

Jeder Arbeitsplatzrechner hat die Speicherkapazität von Milliarden Steintafeln und zig hunderttausenden Büchern, die alle bei einem kleinen Defekt schon unrettbar verloren sein können. Die anfallende Datenmenge steigt auch in Privathaushalten rapide an. Es sind nicht nur die eingescannten Zeugnisse oder die elektronische Steuererklärung, es sind vor allem Bilder und Videos, deren Speicherplatzbedarf stetig steigen.

Niemand braucht soviel Speicherplatz!

Nicht nur Bill Gates blamierte sich mit der Aussage, dass kein Mensch mehr als 640 KB RAM benötige. Auch Verkäufer erzählten damals gerne: „Die Festplatte hat 10 Megabyte! Die bekommen Sie im Leben nicht voll!“. Heute sagen viele: „Mehr als ein Terabyte große Festplatten benötigt kein Mensch!“. Diese Sprüche haben eines gemeinsam: Sie sind ebenso griffig wie falsch.

Mehr Informationen über den Speicherplatzbedarf

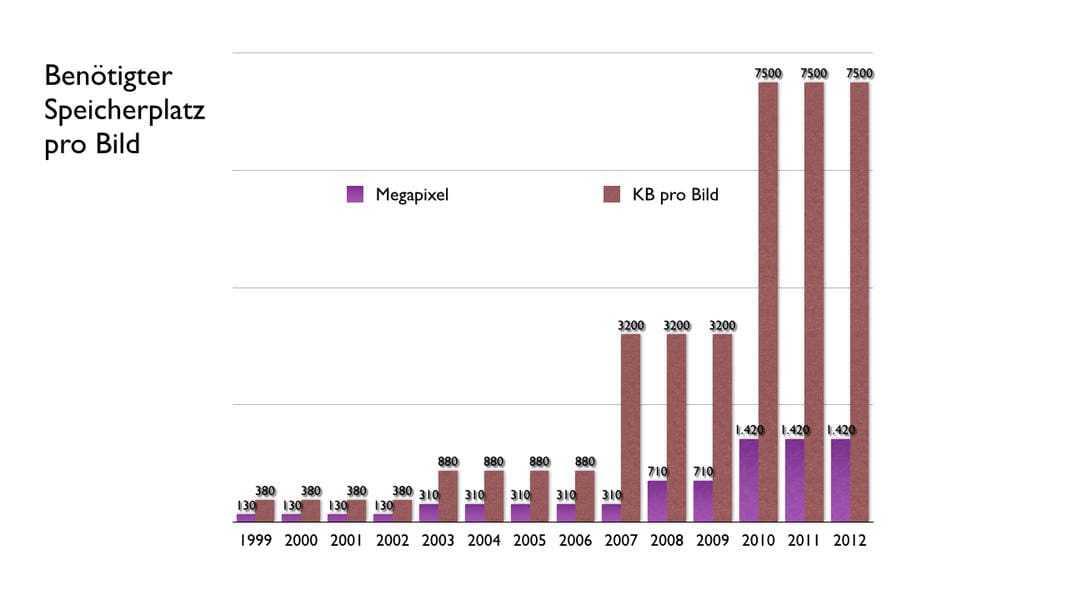

Hatte ein Bild einer guten Digitalkamera mit 1,3 Megapixeln im Jahre 1999 nur rund 400 KB, so waren es fünf Jahre später, bei 3.0 MP Auflösung, bereits 900 KB. Weitere fünf Jahre später waren 7.1 Megapixel üblich – die Speicherkarten größer und billiger, die Komprimierung musste nicht mehr so stark sein – so dass hier etwa 3 Megabyte an Daten für nur ein Bild anfielen. Wieder fünf Jahre weiter machte die Speichertechnologie enorme Fortschritte und immer mehr Kameras speicherten im sogenannten RAW-Format (quasi die Rohdaten aus dem Kamerasensor) mit weniger Komprimierung und dadurch höherer Qualität. Innerhalb von 15 Jahren stieg folglich die Auflösung um mehr als das zehnfache und der Speicherplatzbedarf erhöhte sich auf knapp 13 MB pro Bild.

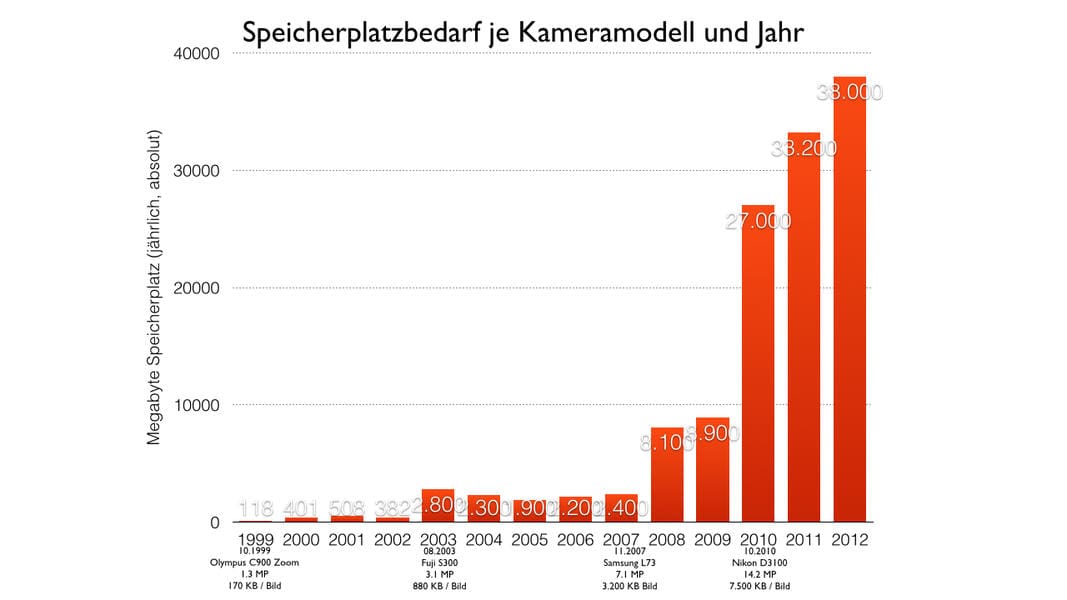

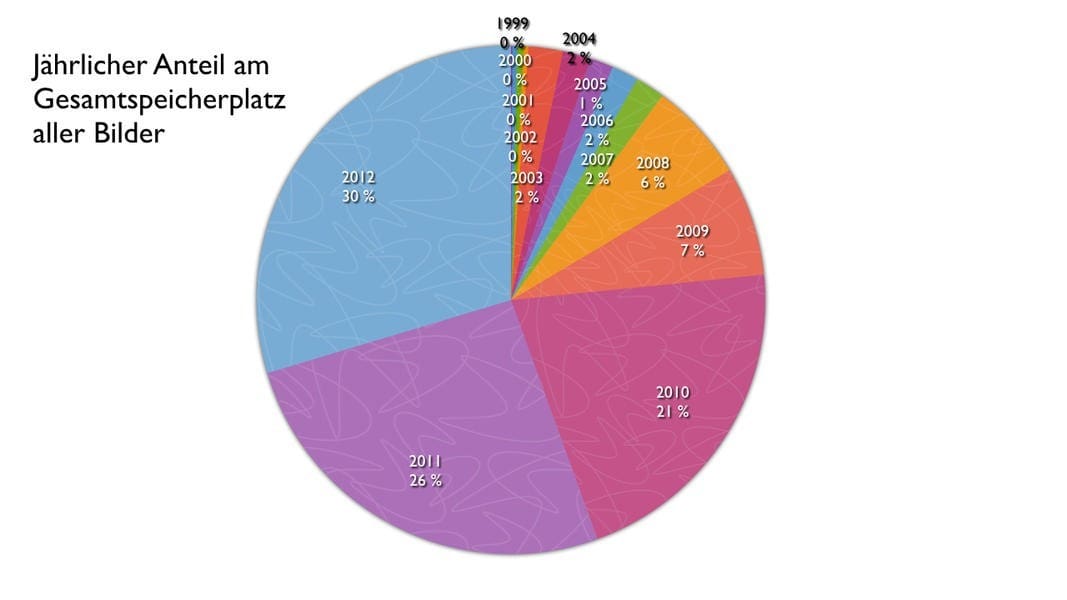

Ein Praxisbeispiel: gehen wir einmal von durchgehend 1.000 Bildern im Jahr aus. In Wirklichkeit steigt die Anzahl der Bilder natürlich an, da die Leute durch die Kameras in den Handys auch mehr fotografieren. Weiterhin gehen wir von einer durchschnittlichen Verdoppelung der Megapixel alle fünf Jahre aus. Grob und vereinfacht gesagt nehmen dann die Bilder der neuen Kamera bereits nach etwa zweieinhalb Jahren mehr Platz weg als alle Bilder zusammen, die man in den Jahren davor geschossen hat.

Hier als Beispiel meine eigene Mediathek für den Zeitraum zwischen 1999 und 2012:

(Wie viel Speicherplatz benötigt ein einzelnes Bilde der jeweiligen Kamera? Hier die Steigerung im Laufe der Jahre)

(Wie viel Speicherplatz nehmen die Bilder der Kamera pro Jahr insgesamt für sich in Anspruch?)

(Wie viel Platz nehmen die Bilder der jeweiligen Jahre prozentual von der gesamten Bildersammlung in Anspruch?)

Ein Familienvideo in FullHD (1080p) benötigt um die 260 Gigabyte pro Stunde – also das zwanzigfache. Mit Actioncams, die mit höherer Bildwiederholfrequenz aufnehmen können, kann sich dieser Wert mehr als verdoppeln. Das SD-Video (576i) einer Mini-DV-Kamera benötigte hingegen nur 12 GB pro Stunde. Anders ausgedrückt: 1 Stunde HD-Video benötigt soviel Speicherplatz wie 20 Stunden SD-Videomaterial. Das liegt zum Teil auch an der vergrößerten Farbtiefe der HD-Videos. 4K-Videos benötigen etwa das 12-fache des Speicherplatzes von HD-Videos, also bereits 3TB die Stunde. Bei 8K sind wir im professionellen Bereich bei rund 10 Terabyte pro Stunde. Diese Werte schwanken teils sehr stark, jeweils abhängig von dem gewählten Komprimierungsverfahren und -stufen.

Man sieht: 1 Terabyte Speicherplatz ist „nichts“.

Datenverlust vorprogrammiert?

Die Datenmengen steigen – und damit auch die Gefahr eines Datenverlustes, da das einzelne Bild immer mehr Platz auf der Festplatte belegt, aber die Datensicherheit des Mediums an sich nicht zugenommen hat. Bereits im Jahr 2007 hat das CERN eine Studie zur „Silent Data Corruption“ veröffentlicht, bei der von 33.700 Dateien bereits 22 Dateien nicht mehr korrekt lesbar waren. Und hierbei handelte es sich um ein Serversystem mit den dort üblichen Sicherheitssystemen zur Abwendung eines Datenverlustes. Rechner im Haushalt sind weit, weit unzuverlässiger.

Mehr Informationen zur Gefahr des Datenverlustes

Wir können also davon ausgehen, dass mindestens eines von 1.000 Bilder nicht mehr lesbar ist. In meiner eigenen digitalen Bildersammlung befinden sich etwa 64.000 Bilder. Ich kann also davon ausgehen, dass bereits 64 Bilder zerstört wurden. Da ich natürlich diese Bilder in den vergangenen 17 Jahren zig mal beim Aufrüsten des Rechners von einer Festplatte auf eine andere kopiert habe, steigt die Fehlerrate natürlich massiv an. Videos, die viel mehr Platz benötigen als Bilder, sind gefährdeter, da bei einem komprimierten Videos ein einzelner Fehler bereits irreparabel sein kann.

Aber selbst wenn man heute eine Festplatte, eine SSD, eine Bluray-Disc oder einen USB-Stick mit dem (fehlerfreien!) Backup der Familienphotos und -videos in einen Tresor legt, so werden bereits unsere Enkel nicht mehr ohne weiteres in der Lage sein, sich diese Bilder und Videos anzusehen. Die Festplatten finden schlicht keinen geeigneten Anschluss am PC – oder was man dann auch immer als PC-Ersatz benutzt. Für die Bluraydiscs wird es längst keine Laufwerke mehr geben und auch USB-Sticks werden nicht mehr an den Rechner passen. Von dem Dateisystem, auf dem diese Daten gespeichert wurden, oder den modernen Übertragungswegen wie HDMI, die Bild und Ton nur an „authorisierte“ Geräte ausgeben, gar keine Rede.

Babylonische Formatvielfalt

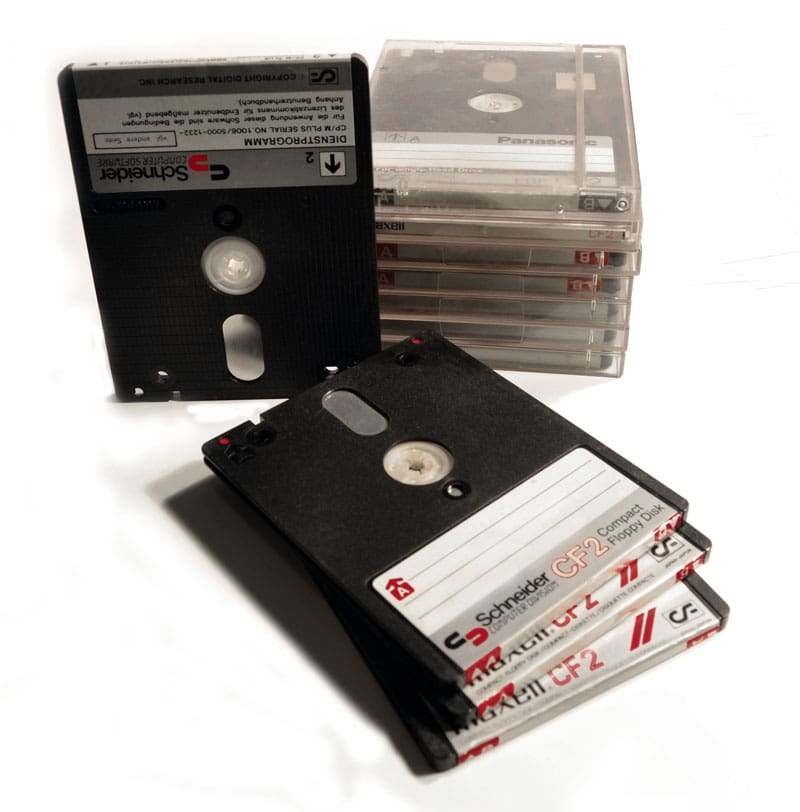

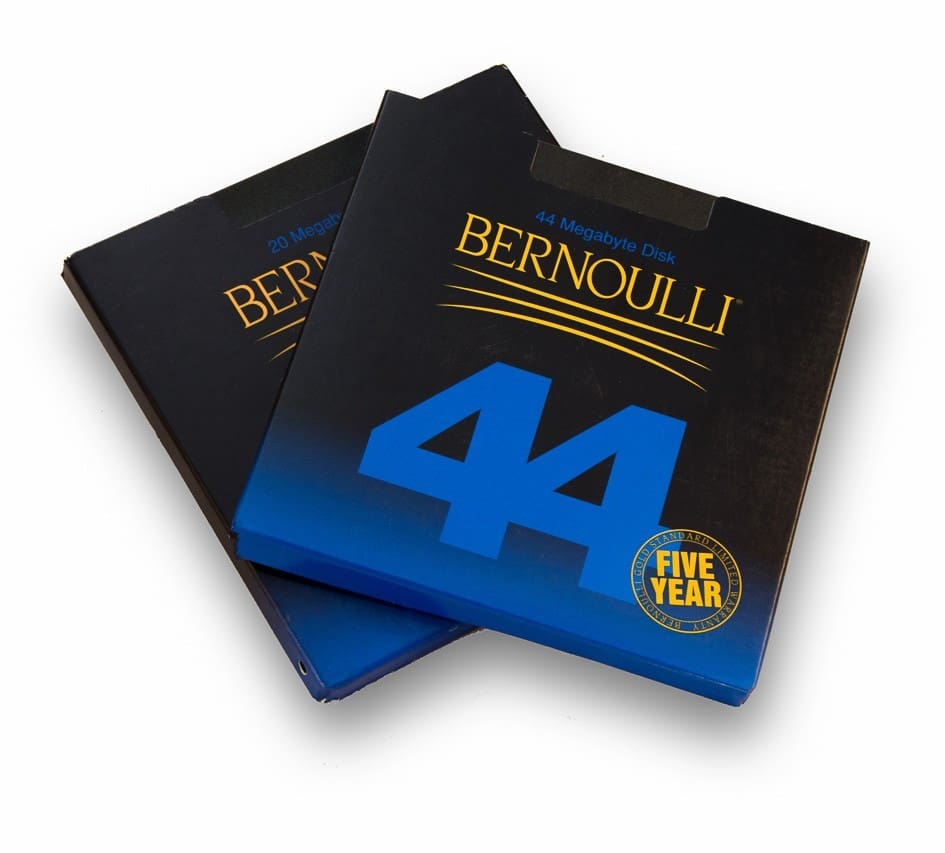

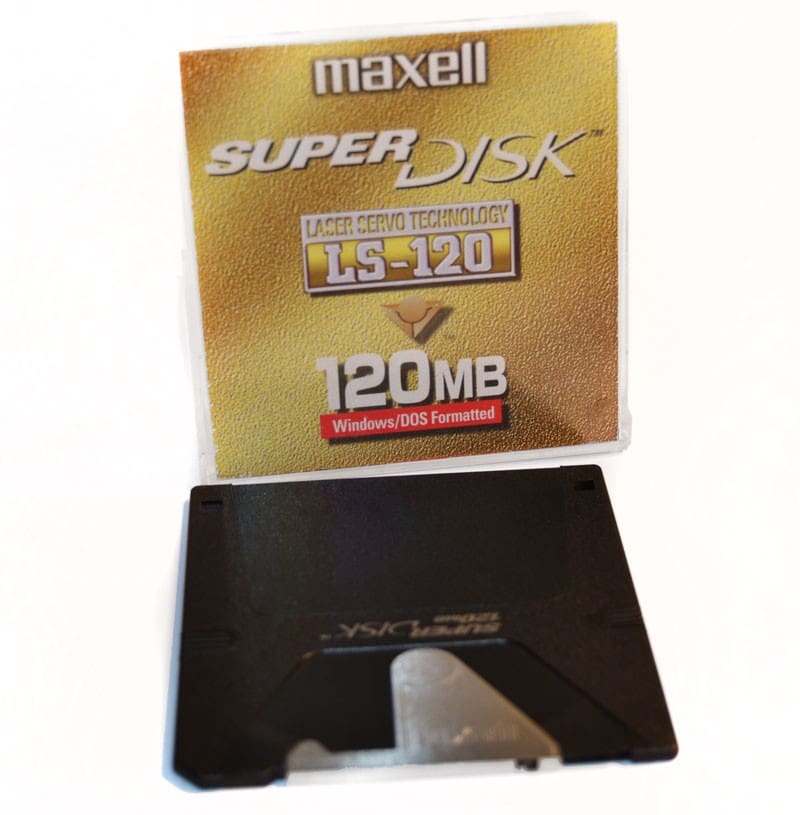

Kann Dein aktueller Computer die Dokumente lesen, die Du vor 20 Jahren Deinem DOS-PC anvertraut hast? Moderne Rechner haben kein 3,5 Zoll-Diskettenlaufwerk mehr, geschweige denn eines für die seinerzeit weit verbreiteten 5,25 Zoll Disketten oder die noch größeren und älteren 8 Zoll Disketten. Erinnerst Du Dich noch an Datenträger mit dem Namen Zip, LS120, QIC, DDS, MO oder Microdrive (Sinclair / IBM)? Hast Du gar noch einen HD-DVD-Player zu Hause? Deine Familienvideos befinden sich auf Digital8– oder MiniDV-Kassetten? Die Lieblingssongs Deiner Jugend hattest Du auf DCC oder MiniDisc? Das passende Abspielgerät liegt noch im Keller? Das funktioniert auch noch?

Bist Du sicher?

Hier einige Beispiele für Datenträger, für die man nur noch schwer ein passendes Auslesegerät findet:

Vergessene Datenträger

– Lochkarte

– Video-Data-System: ISA-Steckkarte umd Videorecorder anzusteuern Kapazität auf 8h-Band: 736 MB, Geschwindigkeit: 1,33 MB/min

(Hitachi-Maxell, magnetische 3 Zoll Diskette, 180 KB pro Seite, Anfang 1980er)

(HP/Sony, magnetische DDS-1-Kassette, 2 GB unkomprimiert, 1989)

(Iomega, magnetische Bernouilli-Disk, bis zu 230 MB, 1983)

(SanDisk, offener Flashspeicher SD-Card, ab 8 MB bis zu 2 TB (2016), 2001)

(Iomega/Imation, opto-magnetische 3,5″ Diskette LS-120, 120 MB, 1994)

(3M, magnetische Bandcassette QIC-80, 80 bis 500 MB, 1972)

(SmartMedia-Card (1996, Toshiba, 2-128MB), CompaceFlash-Card (1994, SanDisk, bis 256GB) und xD-Card (2002, Olympus/Fuji, bis 2GB)

(5,25″ Diskette, bis 1,2 MB, Shugart, 1976)

(PCMCIA ATA Card Typ III (PCMCIA-Festplatte), 1991, CompaceFlash-Card (1994, SanDisk, bis 256GB)

(Nintendo Famicon Disk System (FDS), 65 KB, 1986)

Unsere Enkel

Sollten es die Enkel aber doch schaffen, die Datenträger irgendwie an den Rechner anzuschließen, so werden die Betriebssysteme der Zukunft die Dateisysteme und die Bilderdaten längst nicht mehr auslesen können. Es wird so sein, als ob die Daten in einer fremden, längst vergessenen Sprache geschrieben wären. Kennst Du noch die Kodak Photo-CD oder Formate wie aml, lbm oder msp? Daten können aber nicht nur durch das Format der Datei schwer zu lesen sein. Manchmal ich der Ersteller der Datei auch darauf erpicht, dass nicht jeder an die Informationen herankommt, diese also vertraulich sind.

Verschlüsselung ist ein Problem

Ich fange dabei gar nicht mal an von den (freiwilligen) Verschlüsselungsverfahren zu reden, die in unserer überwachten Welt leider immer wichtiger werden. Ich verliere auch kein Wort über die aufgezwungene digitale Rechteverwaltung (DRM) oder das unsägliche TPM, bei dem teilweise niemand so genau weiß, wem die einzelnen Schlüssel gehören, woher sie eigentlich stammen und wer die Kontrolle darüber hat. Das sind weite Themenbereiche, die aber das digitale Erinnern unmöglich machen werden.

Wer besitzt Dein Leben?

Suche doch einmal bei StudiVZ nach einem alten Post von Dir… wie? StudiVZ und SchülerVZ gibt es nicht mehr? Kein Thema, Du bist ja noch bei Wer-kennt-wen! Wie? Die haben auch in den Sack gehauen? Aber bei funonline.de, da geht noch was, oder? Gut, dann suche eben bei Facebook. Wie jetzt? Facebook zu durchsuchen geht praktisch nicht? Du kommst an Deine eigenen Beiträge nur mehr durch mühsames durchblättern der Posts der letzten Jahre ran? Gut, dann sicherst Du Deine Timeline und durchsuchst sie ben online. Wie bitte? Das sichern funktioniert nicht? Da bekommt man nur seine Bilder, nicht seine Beiträge? Tja, Pech gehabt. Wenn Du Deine eigenen Beiträge nun frustriert löschen löschen willst, geht das nur immer einzeln und mit je drei Klicks?

Aha.

Wer hat also die Macht über Deine Daten?

Digitale Daten sind auf der anderen Seite extrem schnell zu vervielfältigen. Das kann schlecht sein, wenn jemand Ihr Bankkonto leer räumt, oder online mit Ihrer Identität im großen Stil shoppen geht.

Das kann aber auch gut sein, siehe den Fall um Edward Snowden. Ihm wäre niemals gelungen diese Datenberge unauffällig außer Haus zu schaffen, wenn er einen Kopierer hätte einsetzen müssen. In der Zeit, in der so ein Gerät eine Seite kopiert, wird ein ganzer Leitz-Ordner auf einen USB-Stick kopiert. Aber nehmen wir an, er hätte diese Daten mitnehmen können, so wäre jede weitere Kopie schlechter lesbar gewesen und er hätte damit nicht so schnell so viele Journalisten auf einmal mit den Informationen versorgen können.

Digitale Daten sind so oder so gefährdet. Entweder, weil vertrauliche Daten in falsche Hände kommen können, oder weil sie von eher flüchtiger Natur sind.

Datenschutz und Bildung im Neuland

Wir freuen uns über Whistleblower. Sie stehen ungeachtet ihrer Beweggründe für Demokratie und (digitale) Freiheit. Auf der anderen Seite wollen wir aber ebenfalls die (vermeintliche) Kontrolle über unsere eigenen Daten behalten. Facebook ist böse, Google eine üble Datenkrake. Alle wollen mit unseren Daten Geld verdienen. Also geben wir ihnen so wenig Daten wie möglich. Glauben wir jedenfalls. Jeder, der das Netz benutzt hinterlässt aber auch immer Spuren. Und sei es die Kombination aus der Hardware und Software, die wir benutzen, die einem Fingerabdruck schon sehr nahe kommt. Stichwort: Browser Fingerprinting.

In Zeiten des Terrors glauben viele, dass „bessere“ Gesetze mehr Schutz bieten würden. Alle diese Gesetze haben aber nur ein Ziel: noch mehr Überwachung! „Aber ich habe doch nichts zu verbergen!“, hört man den deutschen Michel, der einem Gartenzwerg gleich, staunend über Merkels Neuland blickt, dabei aber vergisst, wer wirklich der größte Datenhändler ist.

Google Earth schaut in Eure Vorgärten?

Falsch!

Facebook verkauft Deine Wohnanschrift?

Falsch!

Es sind die Gemeinden, die uns ausspionieren und unsere Daten verschachern. Jeder Häuslebauer hat schon einmal eine Berechnung über die versiegelte Fläche seines Grundstückes bekommen. Das hat die Gemeinde nicht Google Earth nachgesehen, nein! Sie hat selber die Bilder von den Häusern der Bürger machen lassen. Sie erhebt selber, wie alt die Autos im Schnitt im Wohngebiet sind. Und danach werden die Daten der Bürger im Paket verkauft.

Das Internet vergisst nicht?

Wir hören auch oft: “Das Internet vergisst nichts!”. Das macht es nur sehr kurzfristig nicht, wie jeder merkt, der im Datenmeer nach technischen Unterlagen oder Berichten aus erster Hand zu politischen oder gesellschaftlichen Ereignissen fischt. Geht man nach dem Internet, so existiert die Menschheit erst ca. Mitte der 1990er Jahre – alles was davor geschah, findet man nur noch als später niedergeschriebene Berichte. Zeitgenössische Artikel aus den 90er Jahren und früher haben es kaum in das weltweite digitale Netz geschafft, auch wenn es auch dafür Bestrebungen gibt.

Als plakatives Beispiel kann ich die Zeitschrift c’t aus dem Heise-Verlag nennen. Da der Verlag keine Rechte an der abgedruckten Werbung innehält, findet man diese auch nicht in den digitalen Heftarchiv. Das ist tatsächlich ein Verlust, wenn man nicht nur die reine Information benötigt, sondern sich auch ein umfassenderes Bild der Zeit machen möchte, in der der Artikel entstand. Werbung bleibt im Kopf, das ist keine Binsenweisheit. Für den Privatgebrauch schnitt ich einmal unterschiedliche Fernsehwerbungen zusammen. Hauptaugenmerk richtete ich auf Werbung für Computer und Videogames. Diese mischte ich mit Werbung von Versicherungen, Waschmittel, Süßigkeiten und Kraftfahrzeugen. Auf Ausstellungen zeigte ich das Video vielen Besuchern. Alle staunten selber darüber, dass sie die technik-fremde Werbung zeitlich viel näher an der Gegenwart verorteten, als die für die digitalen Geräte.

Rettungsbemühungen

Mittlerweile gibt es Bestrebungen, wie das Projekt Gutenberg, alte Schriften in die digitale Welt zu retten, aber sind die daraus erstellten Dateien auch wirklich sicher? Werden die Computer in 100 Jahren diese Dateien überhaupt noch lesen können?

Selbst wenn die Daten noch physikalisch lesbar wären und nicht durch Alterungserscheinungen auf dem Medium unrettbar verloren sind, so mangelt es immer an den Lesegeräten, denn diese wurden meist dem Recycling zugeführt.

(CD-RW-Laufwerk, bis 900 MB Taio Yuden, 1988)

Arten von Daten (grobe Einteilung)

Private Daten

Diese sind dezentral gespeichert. Zyniker könnten anführen, dass die NSA und andere Geheimdienste diese Daten „für uns“ speichern würden, aber selbst dafür fehlt denen die Speicherkapazität. Ich schätze den privaten Datensatz pro Jahr auf ca. 100 GB (Stand 2015), tendenz stark steigend. Mit immer größeren Dauerdatenspeichern (Festplatten/SSDs/SD-Cards) und immer hochauflösenderen Kameras in Fotoapparaten, Videokameras, Mobiltelefonen, Actioncams und Dashcams steigen die anfallenden Datenmengen rapide an. Ob alles davon für die Nachwelt erhaltenswert ist, sei dahingestellt. „Lustige“ Katzenvideos zeichen aber vielleicht ein ähnliches (Zerr-)Bild unserer Gesellschaft wie der Seelenstrip Heranwachsender auf Youtube. Aussortieren und bewerten kann diese aber kein Mensch und (noch) keine Maschine.

Wirtschaftliche Daten

Diese sind ebenfalls dezentral gespeichert. Weltweite Konzerne werden dabei in der Regel ein besseres, zentraleres und umfangreicheres Datenmanagement haben als der kleine Handwerker um die Ecke. Siehe dazu weiter unten: „Big Data“. Aber die Quintessenz dieser Daten wird letztlich dann doch noch zentral auf Staatsebene gespeichert: bei den Finanzämtern.

Staatliche Daten

Unser Staat (Bund, Länder, Kreise und Gemeinden) ist tatsächlich einer der größten Datensammler und -händler. Wer glaubt, dass z.B. die Bilder auf Google Earth vom Google-Konzern gemacht oder gar auch nur beauftragt wurden, der liegt gründlich falsch. Unser eigener Staat macht die hochauflösenden Bilder unserer Häuser und Vorgärten. Spätestens wenn die Wasserwerke die Abrechnung für die Flächenversiegelung mit Luftaufnahmen des eigenen Gründstückes belegen, sollte doch klar sein, welchen Sinn die Aufnahmen haben. Ebenso werden die

Kulturelle Daten

Wie oben angeführt zählen dazu auch Computer- und Videospiele. Bei dem Wort „Kultur“ denkt aber jedermann zu Recht an Literatur, Musik oder bildende Künste. Literatur, Musik und Filme lassen sind gut digital abspeichern. Wenn es aber um klassische Malerei, Buchdruckerkunst oder handwerkliche Künste geht, ist eine digitale Abtastung zwar möglich, wird der Kunst aber vielleicht nicht gerecht. Hinzu kommen rechtliche Fragen wie das Urheberrecht.

Wissenschaftliche Daten

Wissenschaftliche Daten lassen sich heute sehr gut archivieren, denn sie werden meist auch digital veröffentlicht. Aber auch hier gibt es wieder (Urheber-) rechtliche Probleme.

Ist „Big Data“ die Lösung?

Schwierige Frage. Die Grundidee ist dabei das massive Sammeln aller Daten, deren man habhaft werden kann, damit man sie auswerten kann – wenn nicht jetzt, dann vielleicht in einigen Jahren, wenn die Rechenleistung weiter angestiegen ist. Ob die Rechenleistung jemals stärker steigen wird als die Datenmenge ist aber zweifelhaft. Mit unserer heutigen, grundlegenden Computertechnik wird das wohl eher nicht der Fall sein. Wie dem auch sei. Es werden also (weitgehend unkontrolliert) gigantische Datenmengen angehäuft. Aber eben zumeist mit kommerziellen Hintergedanken, weil man hofft, dass diese Daten einen monetären Wert darstellen. Ist es aber von gesellschaftlichen oder kulturellen Interesse, wer wann wo was angeklickt hat, oder wer wann wo etwas gekauft hat? Für das Gesamtbild ist das sicherlich völlig uninteressant. Big Data ist keine Lösung des Problems der digitalen Demenz, denn es würde ewig dauern, aus dieser unvollstellbaren digitalen Müllkippe relevante kulturelle Informationen herauszufiltern – wenn die dort überhaupt gespeichert sind. Für kommerzielle oder geheimdienstliche Belange ist Big Data sicher deutlich interessanter. Als Gesellschaft bringt es uns aber nicht weiter.

Fazit

Die Zeit drängt, denn digitale Daten sind flüchtig und kennen kein verblassen oder abblätternde Farbe. Wenn sie verloren sind, dann für immer. Das Erbe der digitalen Revolution steht auf dem Spiel.

Die Aufarbeitung und Bewahrung der Technologiehistorie ist massgebliche Voraussetzung, in einer immer komplexer und schneller werdenden Welt, die Wurzeln des Computerzeitalters zu verstehen und dadurch dessen Zukunft gestalten zu können.